Aprobado el Reglamento Europeo de Inteligencia Artificial

El Parlamento Europeo y el Consejo de la Unión Europea (UE) han dado luz verde al Reglamento que establece normas armonizadas en materia de inteligencia artificial (IA) con el objetivo de establecer un marco jurídico uniforme para el desarrollo, la introducción en el mercado, la puesta en servicio y la utilización de sistemas de IA en la Unión Europea, de conformidad con los valores de ésta.

El nuevo Reglamento, que entrará en vigor el 1 de agosto y será aplicable en toda la Unión a partir del 2 de agosto de 2026, tiene como fin promover la adopción de IA centrada en el ser humano y fiable, garantizando al mismo tiempo un elevado nivel de protección de la salud, la seguridad y los derechos fundamentales consagrados en la Carta de los Derechos Fundamentales de la Unión Europea, incluidos la democracia, el Estado de Derecho y la protección del medio ambiente, además de proteger a la ciudadanía frente a sus efectos perjudiciales, así como brindar apoyo a la innovación.

Garantiza también la libre circulación transfronteriza de mercancías y servicios basados en la IA, con lo que impide que los Estados miembros impongan restricciones al desarrollo, la comercialización y la utilización de sistemas de IA. La norma comunitaria deja claro que los sistemas de IA pueden desplegarse con facilidad en sectores muy diversos de la economía y en muchas partes de la sociedad, también a escala transfronteriza, y circular fácilmente por toda la Unión. La existencia de normas nacionales divergentes puede dar lugar a la fragmentación del mercado interior y reducir la seguridad jurídica de los operadores que desarrollan, importan o utilizan sistemas de IA.

La norma publicada el pasado 12 de julio en el Diario Oficial de la Unión Europea (DOUE) avala un nivel elevado y coherente de protección en toda la Unión para lograr una IA fiable, así como evitar las divergencias que obstaculizan la libre circulación, la innovación, el despliegue y la adopción en el mercado interior de los sistemas de IA y los productos y servicios conexos mediante el establecimiento de obligaciones uniformes para los operadores y la garantía de una protección uniforme de los fines imperiosos de interés general y de los derechos de las personas en todo el mercado interior.

IA centrada en el ser humano

La normativa contiene normas específicas para la protección de las personas en relación con el tratamiento de datos personales que restringen el uso de sistemas de IA para la identificación biométrica remota, definida como el reconocimiento automatizado de características humanas de tipo físico, fisiológico o conductual, como la cara, el movimiento ocular, la forma del cuerpo, la voz, la entonación, el modo de andar, la postura, la frecuencia cardíaca, la presión arterial...; y de categorización biométrica, es decir, la inclusión de personas físicas en función de sus datos biométricos en categorías específicas como el sexo, la edad, el color del pelo, el color de los ojos, los tatuajes, los rasgos conductuales o de la personalidad, la lengua, la religión, la pertenencia a una minoría nacional o la orientación sexual o política.

También apuesta el Reglamento por la prohibición de las evaluaciones de riesgos realizadas con respecto a personas físicas para evaluar la probabilidad de que cometan un delito o para predecir la comisión de un delito real o potencial basándose únicamente en la elaboración de perfiles de esas personas físicas o la evaluación de los rasgos y características de su personalidad. Una prohibición que no atañe a los análisis de riesgos que utilizan la IA para evaluar la probabilidad de fraude financiero por parte de empresas sobre la base de transacciones sospechosas o para predecir la probabilidad de localización de estupefacientes y mercancías ilícitas por parte de las autoridades aduaneras

En este sentido, las autoridades europeas consideran que el uso del conjunto de tecnologías en rápida evolución que conforman la IA contribuye a generar beneficios económicos, medioambientales y sociales muy diversos en todos los sectores económicos y las actividades sociales, ya que su uso puede proporcionar ventajas competitivas esenciales a las empresas y facilitar la obtención de resultados positivos en ámbitos como la asistencia sanitaria, la agricultura, la seguridad alimentaria, la educación, los medios de comunicación, el deporte, la cultura, la gestión de infraestructuras, la energía, la mitigación del cambio climático y la adaptación a él... al mejorar la predicción, optimizar las operaciones y la asignación de los recursos, y personalizar las soluciones digitales que se encuentran a disposición de la población y de las organizaciones.

No obstante, señala la norma, también puede "generar riesgos y menoscabar los intereses públicos y los derechos fundamentales que protege el Derecho de la Unión. Dicho menoscabo puede ser tangible o intangible e incluye los perjuicios físicos, psíquicos, sociales o económicos". El uso indebido de esta tecnología puede "proporcionar nuevas y poderosas herramientas para llevar a cabo prácticas de manipulación, explotación y control social". Dichas prácticas, señala el reglamento, son "sumamente perjudiciales e incorrectas y deben estar prohibidas".

Por ello, para la UE, la IA, dadas sus importantes repercusiones en la sociedad, debe estar centrada en el ser humano y ser una herramienta "para las personas y tener por objetivo último aumentar el bienestar humano".

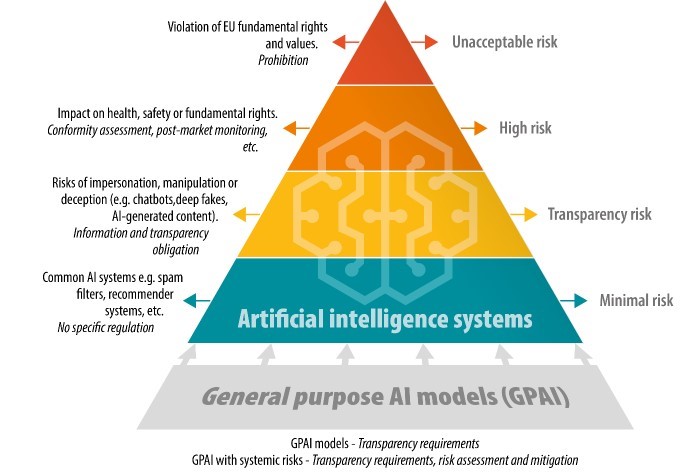

Regulación basada en riesgos

La Comisión que elaboró el Reglamento adoptó un enfoque basado en el riesgo mediante el cual la intervención legal se adaptase al nivel concreto de riesgo, identificándose cuatro espacios de acción:

- Prohibir explícitamente las siguientes prácticas dañinas de IA que se consideran una clara amenaza para la seguridad, los medios de vida y los derechos de las personas, debido al "riesgo inaceptable" que crean:

- Sistemas de IA que utilizan "técnicas subliminales" manipuladoras dañinas;

- Sistemas de IA que explotan grupos vulnerables específicos (discapacidad física o mental)

- Sistemas de IA utilizados por las autoridades públicas, o en su nombre, con fines de puntuación social

- Sistemas de identificación biométrica remota 'en tiempo real' en espacios de acceso público con fines policiales, salvo en un número limitado de casos

- Regular los sistemas de IA de alto riesgo que crean un impacto adverso en la seguridad de las personas o sus derechos fundamentales. El borrador del texto distinguía entre dos categorías de sistemas de IA de alto riesgo. Estos sistemas de IA de alto riesgo tendrían que cumplir una serie de requisitos, en particular en materia de gestión de riesgos, pruebas, solidez técnica, formación y gobernanza de datos, transparencia, supervisión humana y ciberseguridad antes de su comercialización o puesta en servicio. Los sistemas de IA que se ajusten a las nuevas normas armonizadas de la UE se beneficiarían de una presunción de conformidad con los requisitos del proyecto de ley de IA.

- Sistemas utilizados como componente de seguridad de un producto o sujetos a la legislación de armonización de seguridad y salud de la UE (por ejemplo, juguetes, aviación, automóviles, dispositivos médicos, ascensores

- Sistemas desplegados en ocho ámbitos específicos que la Comisión podría actualizar según sea necesario mediante actos delegados

- Los sistemas de IA que presentan un riesgo limitado, como los sistemas que interactúan con humanos (es decir, chatbots), los sistemas de reconocimiento de emociones, los sistemas de categorización biométrica y los sistemas de IA que generan o manipulan contenidos de imágenes, audio o vídeo (es decir, deepfakes), estarían sujetos a un conjunto limitado de obligaciones de transparencia

- Todos los demás sistemas de IA que presenten un riesgo bajo o mínimo podrían desarrollarse y utilizarse en la UE sin cumplir ninguna obligación legal adicional. Sin embargo, la ley de IA propuesta preveía la creación de códigos de conducta para alentar a los proveedores de sistemas de IA que no sean de alto riesgo a aplicar voluntariamente los requisitos obligatorios para los sistemas de IA de alto riesgo

Prácticas de IA prohibidas

El texto final del Reglamento incrementa el número de prácticas de IA no autorizadas, debido a su impacto dañino, respecto a aquellas propuestas originalmente por la Comisión:

- Sistemas de IA que utilizan técnicas subliminales, manipuladoras o engañosas para distorsionar el comportamiento de personas o de un grupo de personas y perjudicar la toma de decisiones informadas

- Sistemas de IA que aprovechen vulnerabilidades debidas a la edad, discapacidad o situaciones sociales o económicas

- Sistemas de categorización biométrica que tengan que ver con la raza, las opiniones políticas, la afiliación sindical, las creencias religiosas o filosóficas, la vida sexual o la orientación sexual (excepto para fines policiales dentro de la legalidad)

- Sistemas de IA que evalúen o clasifiquen individuos o grupos en función de su comportamiento social o características personales, dando lugar a un trato perjudicial o desproporcionado en contextos no relacionados o injustificado o desproporcionado con respecto a su comportamiento

- Identificación biométrica remota en 'tiempo real' en espacios públicos para el cumplimiento de la ley (excepto para objetivos específicos necesarios, como la búsqueda de víctimas de secuestro, explotación sexual o personas desaparecidas, la prevención de ciertas amenazas sustanciales e inminentes a la seguridad, o la identificación de sospechosos en situaciones de delitos graves)

- Sistemas de IA que evalúen el riesgo de que las personas cometan delitos penales basándose únicamente en perfiles o rasgos y características de personalidad (excepto cuando respalden evaluaciones humanas basadas en hechos objetivos y verificables vinculados a una actividad delictiva)

- Sistemas de IA que crean o amplían bases de datos de reconocimiento facial mediante extracción no dirigida de Internet o imágenes de CCTV (videovigilancia)

- Sistemas de IA que infieren emociones en lugares de trabajo o instituciones educativas, excepto por razones médicas o de seguridad

Sistemas de IA de alto riesgo

El Reglamento también identifica una serie de casos de uso en los que los sistemas de IA deben considerarse de alto riesgo, dado que potencialmente pueden crear un impacto adverso en la salud, la seguridad o los derechos fundamentales de las personas:

- Los sistemas de IA de alto riesgo pueden ser componentes de seguridad de productos cubiertos por la legislación sectorial de la UE (por ejemplo, dispositivos médicos) o sistemas de IA que, por principio, se consideran de alto riesgo cuando se utilizan en áreas específicas

- Se incluye una nueva prueba ('disposición de filtro'). Los sistemas de IA no se considerarán de alto riesgo si no suponen un peligro significativo de daño para la salud, la seguridad o los derechos fundamentales de las personas físicas. En cualquier caso, siempre se considerarán de alto riesgo si el sistema elabora perfiles de personas físicas

- Los proveedores de estos sistemas de IA de alto riesgo tendrán que ejecutar un procedimiento de evaluación de la conformidad antes de que sus productos puedan venderse y utilizarse en la UE. Tendrán que cumplir con una serie de requisitos que incluyen pruebas, capacitación de datos y ciberseguridad y, en algunos casos, tendrán que realizar una evaluación de impacto sobre los derechos fundamentales para garantizar que sus sistemas cumplan con la legislación de la UE.

Riesgo de transparencia

Ciertos sistemas de IA destinados a interactuar con personas físicas o generar contenidos pueden plantear riesgos específicos de suplantación de identidad o engaño, independientemente de si se consideran o no de alto riesgo, por lo que están sujetos a requisitos de información y transparencia. Se debe informar a los usuarios que interactúan con chatbots.

Los implementadores de sistemas de inteligencia artificial que generan o manipulan contenido de imágenes, audio o video (es decir, deep fake) deben revelar que el contenido ha sido generado o manipulado artificialmente, excepto en casos muy limitados (por ejemplo, cuando se usa para prevenir delitos penales). Los proveedores que generan grandes cantidades de contenido deben implementar técnicas y métodos suficientemente confiables, interoperables, efectivos y sólidos (como marcas de agua) para permitir detectar que ha sido generada o manipulada por un sistema de IA y no por un ser humano. Los empleadores que implementen sistemas de IA en el lugar de trabajo deben informar a los trabajadores y a sus representantes.

Ámbito de aplicación

El Reglamento de la IA se aplica principalmente a los proveedores e implementadores que ponen en servicio o comercializan sistemas de IA y modelos GPAI (IA de propósito general) en el mercado de la UE y que tienen su lugar de establecimiento o están ubicados en la misma, así como a los implementadores o proveedores de sistemas de IA que están establecidos en terceros países, cuando el producto producido por sus sistemas se utiliza en la UE. Quedan excluidos los sistemas de IA comercializados, puestos en servicio o utilizados por entidades públicas y privadas con fines militares, de defensa o de seguridad nacional.

De manera similar, la ley de IA no se aplicará a los sistemas y modelos de IA, incluidos sus resultados, que se desarrollen y pongan en servicio específicamente con el único propósito de investigación y desarrollo científicos. Además, por principio, el Reglamento no se aplica antes de que los sistemas y modelos se pongan en servicio o se comercialicen (en este caso pueden aplicarse normas de sandboxing, conjunto especial de reglas que permite a las empresas probar sus productos y servicios innovadores en un entorno seguro y limitado, con posibilidad de obtener exenciones de determinados requisitos del marco regulatorio o supervisor o con garantías en caso de incertidumbre regulatoria).

La Oficina y el Consejo de IA

La Oficina Europea de IA será el centro de la experiencia en IA en toda la UE y desempeñará un papel clave en la implementación de la Ley, especialmente para la IA de propósito general, apoyará el desarrollo y el uso de una IA fiable, protegiendo al mismo tiempo contra los riesgos de la IA, y fomentará la cooperación internacional. Ha sido especialmente equipada para apoyar el enfoque de la UE en materia de IA, dando cobertura a los organismos de gobernanza de los Estados miembros en sus tareas y haciendo cumplir las normas para los modelos de IA de uso general. Estas tareas están respaldadas por las competencias conferidas a la Comisión por la Ley de IA, incluida la capacidad de llevar a cabo evaluaciones de modelos de IA de uso general, solicitar información y medidas a los proveedores de modelos y aplicar sanciones. También buscará promover un ecosistema innovador de IA fiable, para cosechar los beneficios sociales y económicos y garantizará un enfoque europeo estratégico, coherente y eficaz en materia de IA a escala internacional, convirtiéndose en un punto de referencia mundial.

Estructrura de la Oficina

La estructura organizativa de la Oficina Europea de IA consta de cinco unidades y dos asesores.

- Unidad 'Excelencia en IA y robótica'

- Unidad 'Regulación y cumplimiento'

- La unidad de 'seguridad de la IA'

- Unidad 'AI Innovation and Policy Coordination' (Innovación en materia de IA y coordinación de políticas)

- Unidad 'AI para el bien de la sociedad'

- El asesor científico principal

- El Asesor para Asuntos Internacionales

Tareas de la Oficina de IA

La Oficina de IA hace uso de sus conocimientos especializados para apoyar la aplicación de la Ley de IA buscando:

- Contribuir a la aplicación coherente de la Ley de IA en todos los Estados miembros, incluida la creación de órganos consultivos a escala de la UE, facilitando el apoyo y el intercambio de información

- Desarrollar herramientas, metodologías y puntos de referencia para evaluar las capacidades y el alcance de los modelos de IA de uso general y clasificar los modelos con riesgos sistémicos

- Elaboración de códigos de prácticas de vanguardia para detallar las normas, en cooperación con los principales desarrolladores de IA, la comunidad científica y otros expertos

- Investigar posibles infracciones de las normas, incluidas las evaluaciones para evaluar las capacidades de los modelos, y solicitar a los proveedores que adopten medidas correctoras

- Preparar orientaciones y directrices, actos delegados y de ejecución y otras herramientas para apoyar la aplicación efectiva de la Ley de IA y supervisar el cumplimiento del Reglamento

La Comisión pretende fomentar una IA fiable en todo el mercado interior. La Oficina de IA, en colaboración con los actores públicos y privados pertinentes y la comunidad de startups, contribuye a ello mediante:

- Impulsar acciones y políticas para aprovechar los beneficios sociales y económicos de la IA en toda la UE

- Proporcionar asesoramiento sobre las mejores prácticas y permitir el acceso inmediato a los espacios controlados de pruebas de IA, las pruebas en el mundo real y otras estructuras de apoyo europeas para la adopción de la IA

- Fomentar ecosistemas innovadores de IA fiable para mejorar la competitividad y el crecimiento económico de la UE

- Ayudar a la Comisión a aprovechar el uso de herramientas transformadoras de IA y reforzar la alfabetización en materia de IA

A nivel internacional, la Oficina de IA contribuye a un enfoque estratégico, coherente y eficaz de la UE:

- Promover el enfoque de la UE con respecto a una IA fiable, incluida la colaboración con instituciones similares de todo el mundo

- Fomentar la cooperación y la gobernanza internacionales en materia de IA, con el objetivo de contribuir a un enfoque global de la IA

- Apoyar el desarrollo y la aplicación de acuerdos internacionales sobre IA, incluido el apoyo de los Estados miembros

La colaboración con una amplia gama de instituciones, expertos y partes interesadas es esencial para el trabajo de la Oficina de IA.:

- A nivel institucional, la Oficina de Inteligencia Artificial trabaja en estrecha colaboración con el Comité Europeo de Inteligencia Artificial formado por representantes de los Estados miembros y el Centro Europeo para laTransparencia Algorítmica (ECAT) de la Comisión

- La Comisión Técnica Científica de expertos independientes garantiza un fuerte vínculo con la comunidad científica a través de un foro consultivo que representa una selección equilibrada de partes interesadas, incluidas la industria, las empresas emergentes y las pymes, el mundo académico, los grupos de reflexión y la sociedad civil. La Oficina de IA también podrá asociarse con expertos y organizaciones individuales. También creará foros para la cooperación de los proveedores de modelos y sistemas de IA, incluida la IA de uso general, y, de manera similar, para la comunidad de código abierto, a fin de compartir las mejores prácticas y contribuir al desarrollo de códigos de conducta y códigos de prácticas

- La Oficina de IA también supervisará el Pacto de IA, que permite a las empresas colaborar con la Comisión y otras partes interesadas, como el intercambio de mejores prácticas y la participación en actividades

Más información

- Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo, de 13 de junio de 2024, por el que se establecen normas armonizadas en materia de inteligencia artificial y por el que se modifican los Reglamentos (CE) n.° 300/2008, (UE) n.° 167/2013, (UE) n.° 168/2013, (UE) 2018/858, (UE) 2018/1139 y (UE) 2019/2144 y las Directivas 2014/90/UE, (UE) 2016/797 y (UE) 2020/1828

- Exposición informativa desarrollo de la Ley de inteligencia artificial (pdf)

- El Reglamento Europeo de IA (resumen)

- Claves para comprender el nuevo Reglamento IA (KPMG) (pdf)